El procesamiento de datos tiene mucho que ver con números, pero ¿qué sucede cuando se trata de letras? ¿Cómo se almacena el texto en memoria y cómo se guarda en un disco duro? Estas preguntas son de vital importancia si deseas profundizar en la programación de software. En esta guía, aprenderás cómo se almacena el texto en forma de cadenas y qué estándares, como ASCII y Unicode, desempeñan un papel.

Principales conclusiones

- El código ASCII asigna caracteres a valores numéricos específicos.

- Unicode amplía el código ASCII para representar una variedad de caracteres de diferentes idiomas.

- Cada letra, cada número y cada símbolo está almacenado en una tabla estandarizada que establece su valor numérico.

Guía paso a paso

1. Entender los fundamentos de las codificaciones de caracteres

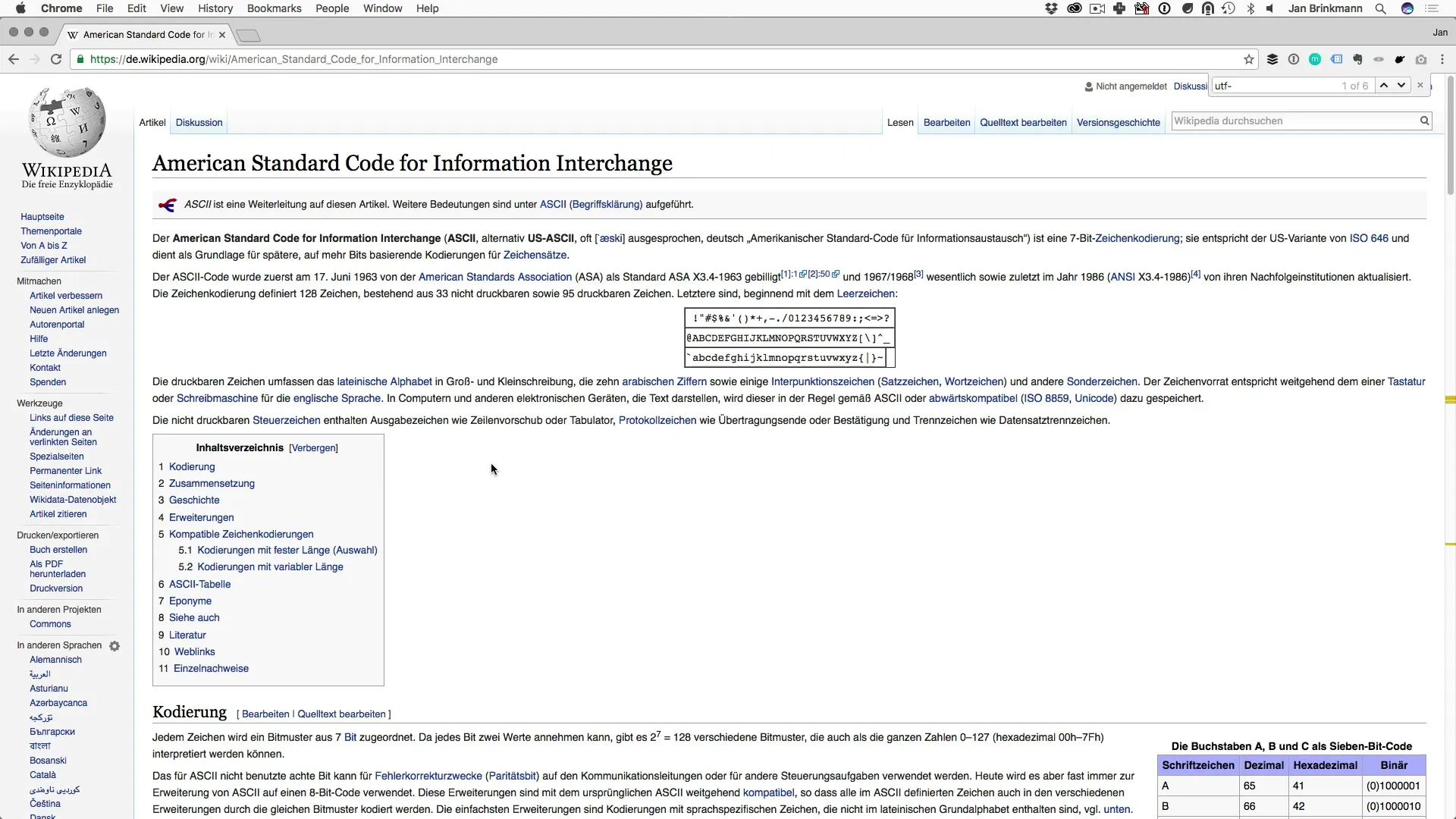

Un punto central en la programación de software es cómo se almacena el texto en memoria. El primer paso es echar un vistazo al código ASCII. ASCII (Código Estándar Americano para el Intercambio de Información) es una codificación que convierte caracteres en valores numéricos. Cada figura, ya sea letra o número, tiene un valor numérico definido por el código ASCII.

2. ASCII y sus aplicaciones

Para tener una idea de cómo se codifican los caracteres, es importante saber que, por ejemplo, el número 65 corresponde a la letra 'A'. Así, si trabajas con un tipo de dato que está definido como cadena y el primer valor en esta cadena es el número 65, en la salida se mostrará la letra 'A'. Esta asignación es fundamental para entender cómo se procesa el texto.

3. La razón de la introducción de Unicode

Con el tiempo, se hizo evidente que ASCII no podía representar los muchos caracteres diferentes del mundo. Mientras que ASCII solo puede mapear 256 caracteres posibles, se necesita algo más para los caracteres globales, más de lo que el sistema ASCII puede manejar. Aquí es donde entra Unicode, que permite una representación codificada de más de 4 mil millones de caracteres.

4. Unicode y sus ventajas

¿Qué hace que Unicode sea tan especial? A diferencia de ASCII, que solo está diseñado para caracteres en inglés, Unicode admite muchos caracteres diferentes de varios idiomas, incluidos chino, japonés y hebreo. De esta manera, se puede asegurar que el texto sea comprensible a nivel internacional.

5. Implementación de caracteres en Unicode

¿Cómo funciona la asignación de caracteres a valores numéricos en Unicode? Cada carácter se asigna un valor específico que luego se utiliza en la programación. Esta asignación permite una variedad de caracteres en aplicaciones de software. Por lo tanto, Unicode es más que una simple codificación; representa una facilitación para la comunicación global.

Resumen: Programación de software para principiantes - Comprender las cadenas en memoria

El mundo de las codificaciones de caracteres es fascinante y abre muchas posibilidades en la programación de software. Has aprendido que ASCII y Unicode son los estándares clave que garantizan que letras y otros caracteres se almacenen correctamente en memoria y en discos duros. Estos fundamentos son cruciales para tener una comprensión sólida al programar aplicaciones de texto.

Preguntas frecuentes

¿Qué es ASCII?ASCII es una codificación de caracteres que asigna valores numéricos a los caracteres.

¿Por qué se desarrolló Unicode?Unicode se desarrolló para representar una variedad de caracteres de diferentes idiomas que ASCII no puede cubrir.

¿Cuántos caracteres puede representar Unicode?Unicode puede representar más de 4 mil millones de caracteres diferentes.

¿Cómo se almacena el texto en un tipo de dato?El texto se almacena en un tipo de dato como cadena, asignando un valor numérico a cada carácter.

¿Cuál es la diferencia entre ASCII y Unicode?ASCII solo puede codificar 256 caracteres, mientras que Unicode ofrece una extensa colección de caracteres globales.